前几天有提到,十二月份的时候去NeurIPS 2019晃了一圈。除了开篇那个演讲之外,那周我还去围观了不少其他的东西。NeurIPS开到如今,万人大会,熙熙攘攘地其实挺难甄别信息的。第一次去这种顶级的计算机会议,经验不足,只能按图索骥般地一点点拾遗。

好在,我目标相对明确,并不是一味的去凑热闹的。那些火到爆的GAN之类的,我就只能远远地围观一眼,然后不明觉厉,去找自己相对更能看懂的东西去了。于是,我就很无聊的,去看了两个主题:因果推断相关的,以及隐私相关的。

因果推断这块儿,能到NeurIPS自然是被选择过的,不会是太纯理论的这种。跟机器学习相关的自然是要跳出简单的线性回归了,否则大家写什么呢?其次呢,就是跳出随机试验的框架,否则哪里用得到那么多高深的预测模型呢?七七八八看了不少poster论文,大部分都是各种花样繁杂的算法。努力地去理解他们的做法,然而却哀叹一声,浮沙筑高台,又有多少可以大浪淘沙始见金。(插曲:后面那个causal inference workshop,直接就是Susan-fest...哎,她也算是扛起来一面大旗了。)

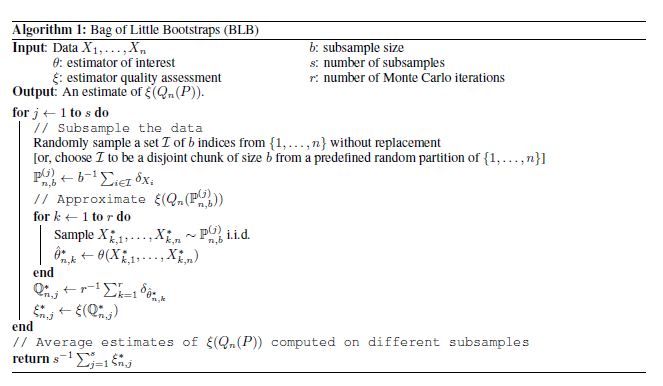

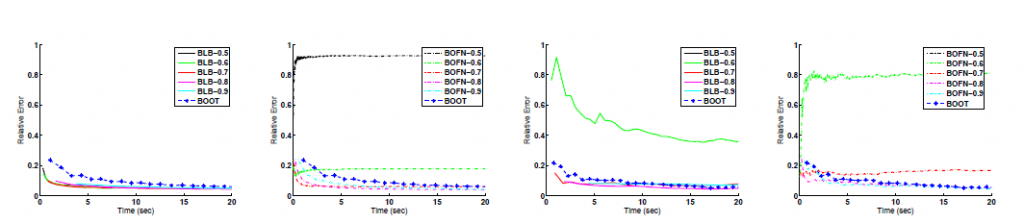

隐私相关的,其实是加密+分布式的结合,基本要实现的是在客户端进行计算而不是需要把原始的隐私数据传递到服务器端。于是乎,我们看到了各种基于分布式算法的演化,加一些随机的因素在里面,就得到了一些隐私友好的算法。也挺好玩的,有助于想清楚一些分布式算法的设计。

笔记本身是用英文整理的,直接在这里贴一份好了。