我又要从方法论上说事儿了。关于计量经济学的应用,着实有一种“泛滥”的感觉。尤其是在前段时间和一些同学争论“格林兰因果检验”的时候,对那种“把统计检验结果奉若至宝”的态度实在是感到心痛 。这种检验也就是摊上了一个好名字,最多可以否定一下因果关系(这还有待商榷),哪能作为肯定的依据?

这两天和Taiyun Wei 、Yihui 两位同学交流甚多,他们都是统计学专业科班出身的,可谓对于统计学的认识颇深。让我这么一个连本专业经济学都还没出师的对于统计、计量的看法和认识深入了很多。确实,计量只是一个工具,不能替代真实的世界中的因果关系(causal-relationship) ,虽然很多计量经济学家都在热衷于这件事儿。

到底,统计学和计量经济学应该在经济学分析中扮演什么角色?

下面是Taiyun Wei 同学不辞辛苦整理贴给我的东西:

-------------------------------------以下引用其原文-------------------------------------

只是统计上的因果,能否定因果关系,却不能反过来支持因果关系。

我之前也这么认为,但是我目前的看法是:统计上的因果,即不能否定因果关系,也不能支持因果关系。之所以说不能否定因果关系,是因为实际条件可能错 综复杂,相互影响、噪声影响可能很严重。还有即便是统计方法,可能不同的方法得到的结果都是不一样的,有的支持有的不支持,这时候应该怎么选择呢?

下面是 我和朋友们的一些讨论,不当之处尽管批评:

这种说法不是没有根据的!Wooldridge在Econometric Analysis of Cross Section and Panel Data开篇就是“因果关系与其他条件不变分析”,阐释了计量经济学对于因果关系的关注。在书的Chaper 18, 专门介绍了Rubin的虚拟事实模型,这在统计学的教科书中几乎是找不到的!不过糟糕的是,中文翻译者根本不懂因果推断,把ignorability翻译 成“不可知性”,差之毫厘,谬以千里!在章,Wooldridge还介绍了Propensity Score以及Principal Stratification(Wooldridge写书的时候Frangakis和Rubin的文章还没有发表,所以后者没有被明确的提出),这些都是 因果的核心概念。

说这些话不是说统计无用,相反,统计很有用,但要具体问题具体分析,用得合适、恰当,而不要盲目套模型。但怎么用得恰当,可是很大的一个问题。正如号称经济学家的人那么多,但真正会用的有几个?

------------------------------------引用结束-----------------------------------------

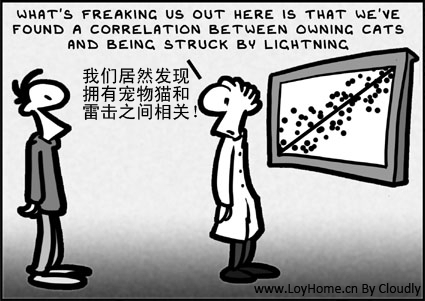

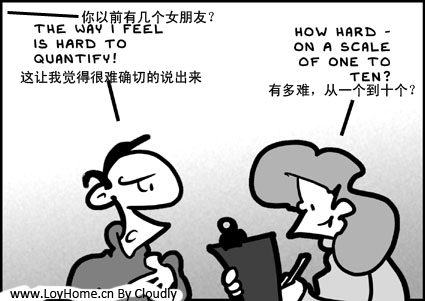

看完之后,我的心里颇为一沉,印证了很多我在现实中隐隐约约体会到的对于计量经济学应用(尤其是初学者滥用)的疑惑。虽然其中某些观点稍显偏激,但是在现实中的事实是,太多的急功近利的行为导致了计量经济学、统计学的滥用。经济学专业的学生不去关注经济规律本身和客观的物质世界,只知道一头埋在统计数据里面企图挖掘出来什么鲜为人知的关系 。这说明了人们的思考角度已经不是事物本身,而实证检验的英文原文empirical指的是"经验主义" ,而不是中文那般美化的仿佛就是现实中的必然规律似的。太多人忽视了统计应用的前提假设,胡乱把一堆例如结构方程模型(SEM)和数据包络(DEA)的东西随便应用到自己的分析中去,而不去严格的证明为什么可以这么用,为什么不会导致结果失真(或许他们也根本证明不了、没有意识去证明)。到这里,我不得不悲哀的说,这已经不是一个方法论的问题,而是彻底的世界观出问题了——认知世界怎么能全部依赖统计 ?

然后看了Yihui 写的一系列文章(三篇,针对低年级统计学专业学生的),外加一两篇分析。网址分别列出,只挑选其中部分内容转载。

----------------------------------------引用开始------------------------------------------

我们先看最简单的一个例子:t检验。我想只要是个学统计的必然都知道这个检验,它是用来检验位置参数的,比如单个样本的 均值是否为0,两样本的均值是否无差异,等等。我们也都知道这个线索:t检验需要t统计量,而t统计量的来历是独立的正态随机变量与卡方随机变量平方根之商(卡方要除以自己的自由度),实际应用中,这里的分母往往就是样本标准差。在t分布被Gosset发表之前,人们往往只能用总体标准差作为分布构造标准 正态随机变量来做检验和估计,Gosset的t分布伟大贡献在于,我们可以用可知的样本标准差替换不可知的总体标准差而且构造t统计量,这下就让人放心多 了,因为我们总是畏惧未知的总体(或者未知的参数),而且在小样本情况下更为畏惧——样本量太少我们就更不敢对总体标准差作出估计。

Gosset的确帮助我们解决了个大麻烦,然而t检验仍然要假设总体服从正态分布,这个麻烦可不好解决。可能马上就会有人说,分布也是可以检验的啊。没 错,是可以检验,比如著名的KS检验;问题就在于,统计分布检验的备择假设太大,我们做假设检验只能有把握得出“样本不服从某种分布”,而不能说“根据检验,样本服从某种分布” :因为犯第一类错误的概率可以控制,而第二类错误的概率只有鬼才知道(不干鬼的事,鬼也许也不知道)。

第二个例子我想稍微说一点关于抽样调查中的统计推断,这里面的统计推断往往比较简单,大致原理就是用样本均值估计总体均 值,样本方差估计总体方差,为什么能这样呢?因为这些估计量往往都是无偏估计,不妨仔细想想“无偏”的意思:期望等于真值 ;注意不是估计量等于真值,那期 望是什么意思呢?通俗来讲,期望就是一个随机变量按照它的分布不停地变变变,变了无数次之后我们看它在“平均”意义下取值为多少,当然抽样工作不可能一遍 一遍无穷做下去,我们一般仅有一次抽样,得到的估计量也就只有一个值,这一个孤零零的估计值,到底离真实值有多远? 只能再去问问鬼。此时可能又有人会说, 我们不是还有方差吗?不是可以做置信区间的估计吗?没错,书上都是这么写的。方差有什么用呢?书上说了,方差是度量离散程度的,试着想一下,告诉你一个随 机变量均值为100,方差为1000,你能想出所谓的“离散程度”是怎样的吗?恐怕也难以想象,所以除非方差为零,否则我一向觉得它在描述统计中并没多大 实际意义(它的确是刻画离散程度的,但怎样叫大怎样叫小?没有标准)。再看置信区间,要谈置信区间一般也就不可避免要用到分布,于是假设条件又来了,一方 面是总体独立同分布,另一方面样本量足够大,这样才能根据中心极限定理构造正态分布随机变量。显然,两个问题来了:抽样能保证独立同分布吗?怎样的样本量 才算作大?又是不好回答的问题。例如分层和整群抽样,很能让人怀疑样本的独立性;而大样本的问题,从数理统计角度(中心极限定理)来看,必须是样本量趋于无穷,显然这是不可能的,若样本量趋于无穷了,那我们还抽什么样?

-我们的下一代必是男孩!-但是他们是选择样本! 其实,关于统计模型的这种质疑,也不是机器学习出现后才开始有的,以前看Gujarati的"Basic Econometrics"一书,曾经读到一段很有意思的话:

Economists' search for "truth" has over the years given rise to the view that economists are people searching in a dark room for a non-existent black cat; econometricians are regularly accused of finding one.

经济学家们“在一间黑屋子里找一只本不存在的黑色的猫”,而计量经济学家往往会宣称他们找到了一只这样的猫。 听起来很可笑,但从某种意义上来讲,我们何尝不是在做这样的事情?

----------------------------------------引用结束------------------------------------------

原文:谢益辉:关于统计推断的一些惴惴不安

这一篇可谓是最通俗的说明了他的所有观点的,此外还有几篇文章:

个人认为都是非常值得一看的。不再直接粘贴过来原文,敬请直接移步。

注,漫画英文来自:http://myhome.iolfree.ie/%7Elightbulb/Research.html 由我翻译为中文并直接修改图片。